Donner de l’importance à la modération des contenus est primordial dans notre société numérique. Mais comment réguler efficacement les publications en s’adaptant aux nouvelles formes de dérives sur internet et comment le faire de manière équitable ? Actuellement, c’est le cas du réseau social X qui pose question…

La modération des contenus fait partie intégrante de la gestion des plateformes. Ces dernières années, elle a dû croître simultanément à l’augmentation de l’utilisation des réseaux sociaux et s’adapter à toutes ses formes de dérives. De l’intelligence artificielle en passant par les non-fungible token (NFT) ou encore les deepfakes et la réalité augmentée, une régulation des contenus semble nécessaire. En Europe, TikTok a le plus grand nombre de modérateur-trice-s humain-e-s suivi par Facebook et Instagram. Ces nettoyeur-euse-s du web ont quelques secondes pour décider de l’avenir des contenus postés : accepter cette image choquante, supprimer cette fake news ou encore ignorer ce signalement pour incitation à la haine. Ces modérateur-trice-s humain-e-s travaillent au gré des directives de leur employeur-euse avec une plus ou moins grande sensibilité selon la plateforme.

Du côté de X, le réseau social a publié fin novembre 2023 son premier rapport de transparence sur le contrôle des contenus, exigé par l’Union européenne. Après analyse, la modération de la plateforme a été jugée insuffisante et une enquête approfondie a été demandée. Ce constat n’est que peu surprenant.

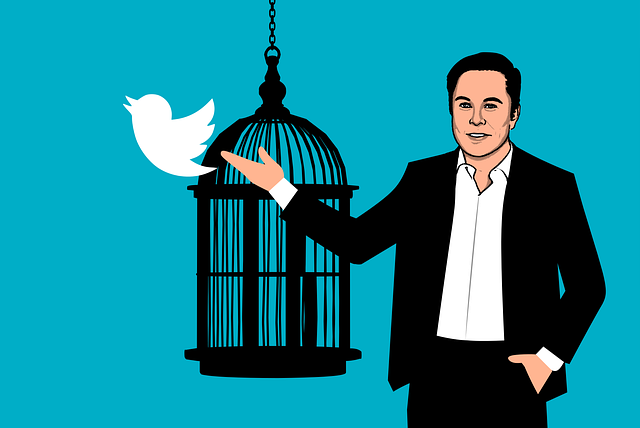

En effet, depuis octobre 2022 et le rachat du réseau social X par le fantasque milliardaire Elon Musk, la réorganisation stratégique est quasi totale sur la plateforme. Le nouveau propriétaire voit son acquisition comme un nouvel espace de liberté d’expression absolue. À l’échelle mondiale, c’est plus de 50 % du personnel qui a été licencié. Les équipes Trust and Safety qui s’occupent de la sécurité des utilisateur-trice-s sont affaiblies tandis que l’équipe Droits de l’Homme a été supprimée. Ce réaménagement impacte forcément la modération des contenus sur la plateforme.

Quand la modération des contenus devient inéquitable

Avant “l’ère Musk“, le réseau social X n’était déjà pas très égalitaire dans sa modération. C’est ce qui ressort d’une recherche menée par Valentine Crosset, Maître-assistante au Medialab de l’Université de Genève. « Dans ces espaces de régulation, on met les mêmes conditions mais ce n’est pas les mêmes retombées, selon comment on gère l’énonciation », c’est par ces mots que la chercheuse a présenté les résultats de son étude au congrès annuel de la SSCM à l’Université de Neuchâtel. Valentine Crosset a analysé près de 200 tweets par jour, ceux-ci étaient tirés aléatoirement parmi 5’000 tweets en live et ceci pendant près d’une année. Ils étaient choisis selon ce que les utilisateur-trice-s dénonçaient en ligne avec les mots-clés « supprime » ou « signale ». Ces contenus ont ensuite été classés selon la taille de l’offenseur-euse, le style de l’offense, le niveau de langage ou encore les diverses régulations émises à leur encontre.

Il en ressort que certains acteur-trice-s maîtrisent mieux les codes des algorithmes pour échapper à la modération. Parmi eux, des politiques, journalistes ou autres communicant-e-s souvent associés à de “gros comptes”. L’algorithme fonctionne avec des mots-clés et il est, par conséquent, impossible pour lui de repérer les propos implicites ou les sous-entendus véhiculés par ce groupe d’offenseur-euse-s, très connaisseur. A l’inverse, les utilisateur-trice-s lambdas, qui détiennent plutôt de “petits comptes”, ont une moindre connaissance du fonctionnement des algorithmes, des lois et n’ont pas cet art énonciatif implicite. Ils sont donc davantage sujets à la censure de leurs propos.

La chercheuse en conclut qu’il existe une forme d’inéquité face à la modération des algorithmes et une tension au niveau des normes de régulation et de suppression entre les deux groupes : les contenus des « gros comptes » pouvant perdurer dans le temps face à ceux des « petits comptes » immédiatement signalés et supprimés par le réseau social. Ce fonctionnement ambivalent pose des questions d’égalité dans la prise de parole. Modérer, oui, mais équitablement. Voilà l’un des prochains défis pour la modération des contenus à l’avenir.

Cette 24ème conférence annuelle de la SSCM/SGKM est couverte médiatiquement par les étudiant-e-s en Master de Création de contenus et communication d’intérêt général (MA3CIG) de l’AJM. Cet article a été réalisé dans le cadre du cours Création de contenus web et réseaux sociaux et fait partie d’une série éditoriale répartie en trois rubriques présentes sur la page du site Pointcomm dédiée à l’évènement.